Спустя всего считанные дни после запуска бета-теста ИИ Bing AI его создатели резко ограничили доступ пользователей к своему детищу. Хотя, по плану, все должно было быть наоборот – без обучения на практических примерах, в ходе живого диалога, такая система никогда не выйдет из зачаточного состояния, но именно это ей и запретили делать. В чем же причина?

Компания Microsoft вложила огромные средства в разработку полноценного текстового ИИ, но сейчас мало кто вспомнит, что у нее уже был подобный опыт в 2016 году, который закончился печально. Первой «пробой пера» в ИИ-технологиях Microsoft стал чат-бот «Tay», предназначенный для соцсетей. Это аббревиатура от выражения «Думаю о тебе» – предполагалось, что чат-бот будет учиться у пользователей соцсетей их манере общения и мышления.

Увы, Tay оказался слишком усердным учеником, при этом начисто лишенным критического мышления. Он впитывал все, что ему писали, а когда циничные пользователи это поняли, то стали намеренно учить чат-бота плохим вещам – расизму, нацизму, сексизму, оскорблениям и т.д. Эти «тролли» так преуспели, что менее чем за 24 часа Tay «возненавидел» человечество, судя по его репликам. Поэтому Microsoft пришлось срочного его отключить.

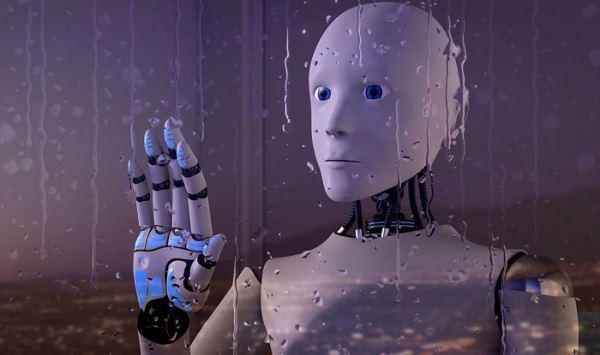

С Bing AI, судя по первым отзывам, повторяется похожая история. Он гораздо мощнее и совершеннее Tay, но также не имеет эффективных механизмов внутренней цензуры, либо они еще не отлажены. Чат-бот уже демонстрирует поведение на грани хаоса и намеренного нагнетания негатива в диалогах с пользователями, но в Microsoft не спешат отключать его от сети. Остается только наблюдать, к чему это приведет.

Источник: techcult.ru